Le classique du cinéma 2001 :L'Odyssée de l'espace revient au cinéma dans une version rafraîchie. Le personnage principal du film est HAL 9000, un ordinateur qui peut parler, voir, planifier et comprendre les émotions. À quel point sommes-nous proches d'un véritable HAL aujourd'hui ?

Commençons tout de suite avec l'une des scènes les plus effrayantes de 2001 :A Space Odyssey. Nous savons que le vaisseau spatial Discovery One est en mission secrète, dont seul HAL connaît la destination finale. L'ordinateur IA contrôle totalement et est, comme le décrit l'écrivain Arthur C. Clarke, "le cerveau et le système nerveux du navire".

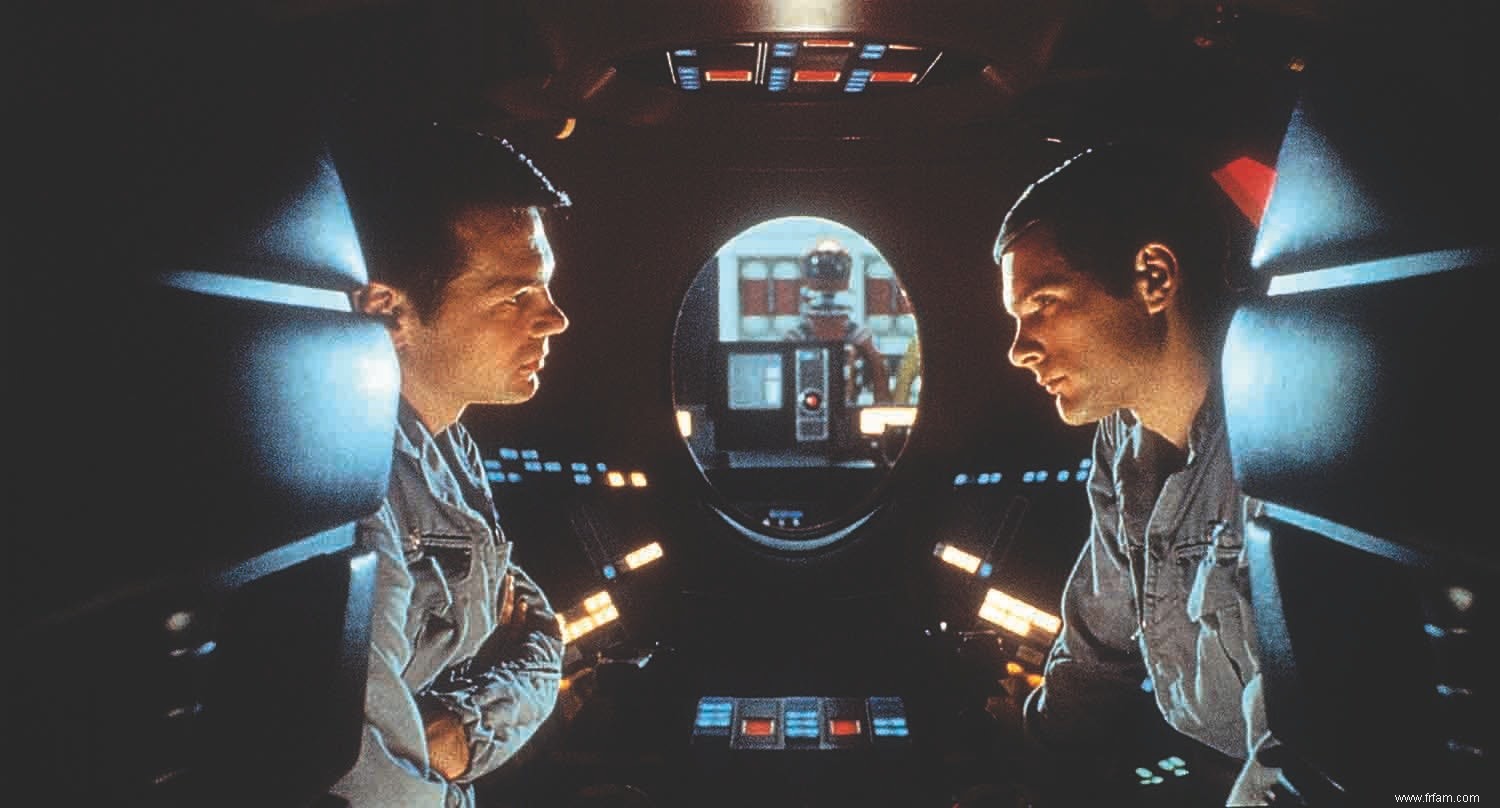

Dans la scène en question, on voit les astronautes Frank et David se retirer dans une nacelle. Ils éteignent l'électronique pour que HAL ne puisse pas les entendre et décident de l'éteindre. Alors qu'ils partagent leurs doutes dans la capsule, nous voyons en tant que spectateur - du point de vue de HAL - qu'il lit sur les lèvres. Afin de ne pas compromettre la mission, HAL décide alors que l'équipage doit être retiré. Clarke a déclaré au New York Times en 1999 que cette scène était l'idée du réalisateur Stanley Kubrick. Lui-même pensait qu'un ordinateur à lecture labiale était le seul élément "techniquement improbable" du film.

Mais regardez, à la fin de l'année dernière, un groupe de chercheurs de l'Université d'Oxford a affirmé qu'ils étaient, en collaboration avec DeepMind de Google, les premiers à développer un système d'IA capable de lire sur les lèvres mieux qu'un humain. En utilisant l'apprentissage en profondeur - des réseaux de neurones artificiels avec plusieurs couches de neurones empilés - ils ont alimenté le système, qu'ils ont surnommé LipNet, plus de 5 000 heures de programmation de la BBC. Ainsi, ce système est devenu de mieux en mieux capable de reconnaître les mouvements des lèvres et les mots associés. Alors qu'un lecteur labial professionnel avait correctement lu 12,4 % des mots, LipNet a obtenu un score de 46,8 %.

Lors de précédentes tentatives d'application de l'apprentissage en profondeur à la lecture labiale, les chercheurs utilisaient des mots simples ou des phonèmes, mais les chercheurs d'Oxford utilisaient des phrases entières. De plus, les images présentaient une variation de l'angle entre le haut-parleur et le lecteur labiale. Les lecteurs labiaux humains obtiennent les meilleurs résultats lorsqu'ils voient l'orateur sous un angle de 45 degrés. À un angle de 90 degrés, donc de profil, la lecture labiale est presque impossible, mais c'est exactement ce que HAL a fait dans le film; probablement parce que Kubrick le trouvait plus attrayant sur le plan cinématographique.

La scène de la lecture labiale dans le film nous dit autre chose :HAL ne pouvait pas lire sur les lèvres sans être capable de reconnaître et de comprendre la parole.

« Toute technologie suffisamment avancée est indiscernable de la magie », a dit un jour Clarke. Le monde en plein essor de la reconnaissance vocale y ressemble parfois un peu. Vous lancez un sort, pour ainsi dire – « Alexa, activez Spotify et recherchez… » – et un appareil intelligent exauce votre souhait. Dans le domaine de la reconnaissance vocale, HAL a des descendants modernes sous la forme d'assistants IA tels que Siri, Google Assistant, Alexa et Cortana.

La reconnaissance vocale a été qualifiée de tendance du moment lors du dernier Consumer Electronics Show de Las Vegas en janvier 2017, l'un des plus grands salons du genre. Des entreprises comme Apple, Google, Microsoft et Amazon, ainsi que le chinois Baidu, investissent des millions dans la technologie de la parole et embauchent des scientifiques renommés pour cela. Andrew Ng, professeur spécialisé en IA à l'Université de Stanford, était jusqu'à récemment le scientifique en chef de Baidu. Adam Cheyer a construit Siri pour Apple. Le même Cheyer était auparavant impliqué dans un projet prestigieux du Pentagone pour construire une sorte de HAL 9000, le projet CALO (Cognitive Assistant that Learns and Organizes). Ce n'est pas pour rien que Wired a qualifié HAL de "proto-Siri" il y a deux ans.

Les majordomes numériques reconnaissent de plus en plus ce que veulent leurs utilisateurs. En mai dernier, Google a fièrement déclaré que son système de reconnaissance vocale reconnaissait correctement 95 % de tous les mots anglais, presque aussi bien qu'un être humain. Mais est-ce que Siri ou Google Assistant comprennent vraiment ce que nous attendons d'eux ? Mark Zuckerberg a déclaré sur sa page Facebook l'année dernière que les systèmes de reconnaissance vocale se sont améliorés, mais qu'"aucun système d'IA n'est assez bon pour comprendre les conversations en ce moment".

Mais qu'est-ce que comprendre ? Le professeur David van Leeuwen de l'Université Radboud de Nimègue, spécialiste de la technologie de la parole, explique la différence entre comprendre et reconnaître. La reconnaissance consiste à être capable de produire une représentation textuelle de ce qui est dit. Je crois Google par leurs yeux bleus qu'ils ont mesuré 95 pour cent, mais alors vous n'êtes pas encore là. Pour le comprendre, vous devez également faire quelque chose de significatif avec ce texte. Si cela réussit, il apparaît à l'utilisateur que l'IA vous comprend. Siri et d'autres sont particulièrement doués pour donner l'impression qu'ils comprennent l'utilisateur en ce moment."

La compréhension est donc un concept subjectif :il s'agit de la perception du récepteur. Van Leeuwen :« Les attentes jouent un rôle majeur dans l'évaluation de la compréhension de l'autre. Vous attendez quelque chose de différent d'un enfant que d'un adulte. C'est une échelle continue et je pense que les IA d'aujourd'hui vont un peu plus loin dans ce sens."

Un système d'IA qui comprend ce que dit un utilisateur est une chose, mais un dialogue en est une autre. En décembre dernier, Mark Zuckerberg a présenté Jarvis, un majordome IA qui fait toutes sortes de corvées dans sa maison sur commande :faire des toasts, ouvrir les rideaux, laisser entrer les visiteurs. Via Facebook, Zuckerberg a demandé à ses abonnés quelle voix convenait le mieux à Jarvis. L'acteur Morgan Freeman a reçu le plus de votes et a ensuite enregistré un certain nombre de fragments de texte.

Les anciens systèmes de synthèse vocale fonctionnaient encore en collant ensemble de courts segments (mots, phrases) préenregistrés par un humain. Plus récemment, des entreprises telles que DeepMind (Wavenet) et Baidu (Deep Voice) déploient des techniques de deep learning. Ils enseignent aux systèmes à parler en leur faisant écouter des enregistrements audio bruts de la langue parlée et en les comparant avec des transcriptions du texte parlé. La voix semble souvent un peu mécanique, mais cela peut être résolu avec des synthétiseurs comme Polly d'Amazon. Et Lyrebird a montré en mai ce que le système peut faire en utilisant les votes de Barack Obama, Donald Trump et Hillary Clinton pour faire dire n'importe quoi – bien qu'un peu en bois dans le son. La dernière étape, cependant, consiste à donner la prosodie du texte parlé – rythme, accent et intonation – mais cela est en cours de travail. Le mois dernier, Apple a publié un rapport de recherche sur la façon de rendre Siri plus naturel.

C'est immédiatement évident dès qu'il commence à parler :HAL avait aussi une voix humaine, à savoir celle d'un acteur canadien. Douglas Rain avait été chargé par Kubrick d'enregistrer le texte d'une manière sans émotion. Pourtant, à travers de petites modulations et des changements de hauteur, la voix trahit quelque chose qui rend une voix si humaine :Rain a compris ce qu'il disait. La qualité de HAL peut être vue dans le dialogue court et apparemment simple en haut de ce chapitre. Il n'est pas difficile d'amener HAL à ouvrir les portes. Pour cela, il doit comprendre le concept d'"ouverture", tout comme ce que Dave veut dire par portes. Mais la réponse de HAL est loin d'être simple. Au lieu d'un simple "Non", il commence par des excuses. Il s'avère qu'il suppose que Dave n'aimera pas sa réponse. Ainsi HAL anticipe les émotions de Dave avant même qu'il ait prononcé la phrase qui déclenchera ces émotions. Ces excuses, combinées aux mots "j'ai peur", sont également dérangeantes, car nous, en tant que téléspectateurs, savons que HAL peut ouvrir les portes, mais ne le fera pas. HAL défie Dave avec sa politesse.

Une telle conversation, qui peut se dérouler sans heurts pour les gens, nécessite une énorme réserve de connaissances avec laquelle nous pouvons comprendre l'ambiguïté et la complexité. Mais nous utilisons également ces connaissances comme contexte pour faire la distinction entre les informations potentiellement pertinentes et non pertinentes. Même le supercalculateur Watson d'IBM, malgré la vitesse d'un million de livres par seconde à laquelle il pouvait traiter les informations, avait des problèmes de compréhension du langage et de reconnaissance des intentions lorsqu'ils l'ont laissé participer à l'émission de quiz télévisée Jeopardy. C'est parce qu'il a calculé la probabilité d'une bonne réponse, pas parce qu'il a compris la question comme un être humain.

Grâce aux techniques d'apprentissage en profondeur et aux investissements de plusieurs millions de dollars, les choses évoluent rapidement. Quand le programme d'IA AlphaGo bat le meilleur joueur du monde dans l'ancien jeu de société chinois Go, c'est l'actualité. Cependant, il est presque impossible de comprendre comment fonctionne réellement l'intelligence artificielle complexe. Les scientifiques décrivent également la façon dont les machines apprennent comme une "boîte noire". L'apprentissage automatique et en profondeur repose sur des réseaux de neurones artificiels qui fonctionnent souvent comme le cerveau humain. En octobre de l'année dernière, Nature écrivait à ce sujet:«Malheureusement, ces réseaux sont tout aussi opaques que le cerveau. Au lieu de stocker ce qu'ils ont appris dans un joli petit bloc de mémoire numérique, ils distribuent l'information d'une manière extrêmement difficile à déchiffrer. » Cela inquiète des scientifiques comme Stephen Hawking. La crainte qu'un tel ordinateur IA, tel que HAL, fonctionne et prenne des décisions par lui-même n'est pas irréaliste. "Cela joue dans chaque système que nous construisons", a récemment déclaré Steve Chien, scientifique de la NASA et chef du groupe d'IA, au Smithsonian.

"Alors que nous construisons des systèmes de plus en plus complexes, il devient plus difficile pour nous de comprendre comment ils vont gérer un environnement complexe."

HAL a permis une mission habitée vers Jupiter en 2001 :une odyssée de l'espace, reprenant toutes les fonctions d'un système de contrôle centre. La NASA prévoit d'envoyer des astronautes sur Mars d'ici 2030, une mission qui les emmènera plus loin de la Terre que n'importe quelle mission habitée auparavant. Le contact avec la terre a un retard pouvant aller jusqu'à 40 minutes, donc en cas de difficultés "Houston, nous avons un problème" n'est pas une option.

Cela rapproche l'idée d'un ordinateur IA qui, par exemple, surveille les systèmes pour les fonctions vitales et le bon fonctionnement des capteurs, et identifie et résout également toute irrégularité. L'ancienne scientifique en chef de la NASA, Ellen Stofan, a déclaré lors d'une conférence sur les voyages dans l'espace lointain l'été dernier :"Je n'arrête pas de le dire, nous avons besoin d'un bon HAL."

Arthur C. Clarke a écrit trois suites à son travail de renommée mondiale. La seconde partie, 2010 :Odyssey Two, est déjà terminée. Aurions-nous déjà un HAL en 2061 :Odyssey Three ? Ou ne devrions-nous pas attendre aussi longtemps ?