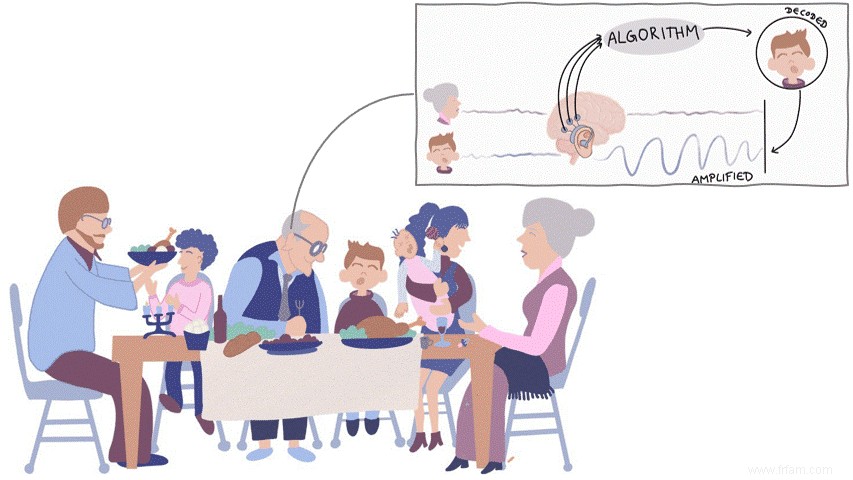

Comment un utilisateur d'aide auditive peut-il écouter une fête de famille ? La nouvelle technologie des ondes cérébrales permet aux utilisateurs d'écouter l'orateur qu'ils veulent vraiment entendre.

Réveillon de Noël. Johan, 76 ans, est assis à la table du banquet avec ses enfants et petits-enfants. Bien qu'il soit très heureux que tout le monde soit ensemble, il se sent seul.

Johan souffre de perte auditive. Il porte une prothèse auditive qui amplifie les sons. Malheureusement, son appareil auditif ne sait pas quelle personne il veut écouter. Le chaos. C'est pourquoi Johan éteint rapidement son aide auditive. Il ne peut suivre aucune conversation et se sent seul. C'est ce que voulait dire l'auteure Helen Keller lorsqu'elle a dit que "la cécité isole les gens des choses, tandis que la surdité isole les gens des gens."

Comme Johan, 1 Belge sur 10 souffre de déficience auditive. Selon l'Organisation mondiale de la santé, ce nombre ne fera qu'augmenter dans les décennies à venir, en partie à cause du vieillissement de la population, pour atteindre 1 sur 4 d'ici 2050. Des aides auditives intelligentes capables d'écouter de manière ciblée sont donc indispensables.

Malheureusement, les aides auditives actuelles ne fonctionnent pas bien dans les cocktails situations, lorsque plusieurs personnes parlent en même temps - pensez à des réceptions, des fêtes, ... L'aide auditive ne sait alors pas quel haut-parleur l'utilisateur veut écouter et amplifie simplement tous les haut-parleurs de la même manière ou prend de mauvaises décisions. Les utilisateurs d'aides auditives ne pourront alors suivre aucune conversation. Peut-être que vous aussi - même sans perte auditive - rencontrez ces difficultés dans de telles situations ?

Une solution possible est d'amplifier l'enceinte la plus proche de Johan. Ou la personne qu'il regarde. Maintenant, Johan veut également écouter ce que son partenaire de l'autre côté de la table dit de lui, ce qu'il n'a pas pu faire depuis des années.

Mais que se passe-t-il si vous entrez directement dans le cerveau de Johan ? pourrait lire à qui il écoutera? C'est seulement là que nous pouvons trouver les informations correctes. C'est exactement ce que nous faisons dans notre équipe interdisciplinaire à la KU Leuven. Nous mesurons l'activité électrique du cerveau via l'électroencéphalogramme (EEG) et utilisez ces données pour savoir qui Johan veut écouter. Nous mesurons cet EEG en plaçant des capteurs sur le crâne.

Mon travail d'ingénieur mathématicien consiste alors à algorithmes pour lire l'EEG et déterminer exactement qui Johan veut écouter. Par exemple, vous pouvez utiliser l'intelligence artificielle de l'EEG pour reconstruire les caractéristiques du signal vocal auxquelles un utilisateur prête attention. En faisant correspondre ces caractéristiques reconstruites avec tous les signaux vocaux captés par l'aide auditive, vous pouvez identifier le bon locuteur. Avec ces informations, l'aide auditive peut alors supprimer toutes les autres conversations et amplifier le bon interlocuteur. Problème résolu !

Vidéo. La démo ci-dessous montre dans un scénario simple avec deux haut-parleurs comment contrôler une aide auditive en reconstruisant les caractéristiques du signal vocal auquel l'utilisateur prête attention à partir de l'EEG.

Nan. L'EEG peut être comparé à une vidéo floue (voir aussi 'Pouvez-vous lire les pensées de l'EEG ?'). L'activité cérébrale pertinente est enterrée sous toutes sortes d'autres activités - d'innombrables processus se déroulent à un moment donné. Donc, pour savoir ce qui se passe sur cette vidéo floue, nous avons besoin de suffisamment de séquences - au moins 30 secondes. Malheureusement, cela prend trop de temps pour Johan. Il ne peut pas attendre 30 secondes pour entendre ce que son partenaire dit de lui de l'autre côté de la table.

Pouvez-vous lire dans les pensées de l'EEG ?Nous reconstruisons les caractéristiques du signal vocal auxquelles quelqu'un prête attention à partir des ondes cérébrales. Pouvons-nous également trouver ce que dit cette personne ? N'est-il même pas possible de déchiffrer ce que vous pensez ?

Heureusement non. L'EEG est une technique non invasive. Cela signifie que nous mesurons les signaux sur le crâne et non sous le crâne. En conséquence, il existe une grande distance entre les capteurs EEG et les neurones - les cellules de base de notre cerveau - qui provoquent une activité électrique en se déchargeant. De plus, le liquide céphalo-rachidien et le crâne amortissent cette activité. Ces processus sont précisément ce qui rend l'EEG si « flou ». Par conséquent, je suis convaincu qu'il est fondamentalement très difficile de reconstruire la parole ou le langage à partir de l'EEG.

C'est pourquoi nous avons développé une nouvelle technique dans notre laboratoire qui, basée sur les schémas cérébraux, détermine dans quelle direction de l'espace Johan dirige son attention. Des collègues de l'Université Columbia à New York ont déterminé que d'autres processus cérébraux sont actifs lorsque vous écoutez à gauche ou à droite, par exemple. En détectant ces schémas cérébraux spécifiques avec l'intelligence artificielle, nous pouvons déterminer très rapidement - en moins de 2 secondes - dans quelle direction quelqu'un écoute. L'aide auditive devrait alors amplifier le haut-parleur à cet endroit spécifique.

La démo ci-dessous montre comment nous pouvons contrôler une aide auditive en déterminant dans quelle direction de la pièce l'utilisateur écoute via les schémas cérébraux.

Bien que cette nouvelle technologie soit très prometteuse en raison de sa vitesse élevée, elle soulève également de nombreuses questions. Par exemple, il n'est actuellement pas clair exactement quels processus cérébraux sont actifs lorsque nous écoutons dans une direction spécifique. La réponse à ces questions aura un impact important sur l'applicabilité pratique de cette nouvelle technique. Des recherches futures devraient le montrer.

La technologie dont il est question ici garantira qu'au cours d'un certain nombre de fêtes de Noël, Johan lui-même pourra orienter son aide auditive vers les conversations qu'il souhaite vraiment entendre. Il reste encore du travail à faire pour concrétiser cette technologie prometteuse. Par exemple, mesurer l'EEG avec des capteurs portables reste un défi. De plus, dans notre laboratoire, nous expérimentons également des algorithmes d'auto-apprentissage qui s'adaptent automatiquement aux nouvelles situations dans lesquelles se trouve l'auditeur. Pendant ce temps, d'autres coéquipiers testent cette technologie dans différents scénarios et environnements.

En surmontant ces obstacles, nous espérons concevoir à long terme une aide auditive contrôlée par le cerveau. De cette façon, Johan peut à nouveau profiter de la fête de Noël avec ses enfants et petits-enfants et il peut enfin entendre ce que son partenaire dit de lui de l'autre côté de la table.

Dans la vidéo ci-dessous, je vous parle de ces nouvelles aides auditives contrôlées par le cerveau.